講座358 子育ての仕方をAIに聞いてみた

ChatGPT(チャット・ジー・ピー・ティー)ってご存知ですか?

2022年11月に公開された人工知能(AI)です。

誰でも使うことができます。

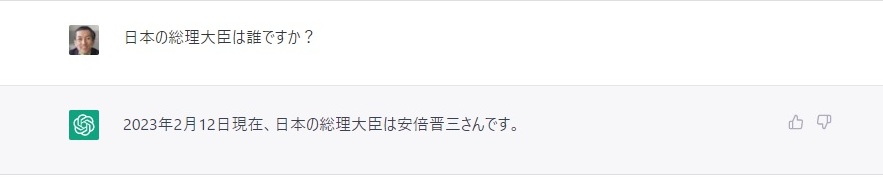

これはユーザー数100万人を達成するまでにかかった日数ですが、ChatGPTはたった5日で100万人が使っています。

皆さんは使ったことありますか?

私は先日、使ってみました。

その時のことを報告します。

2.ChatGPTにしつこく聞いてみる

3.ChatGPTの欠点

4.Perplexityとは

5.現在のAIの限界

1.ChatGPTとは

使い方は簡単です。

ChatGPTのページにアクセスしてメールアドレスと電話番号を登録するだけです。

登録が終わると次のような画面が出て来ます。

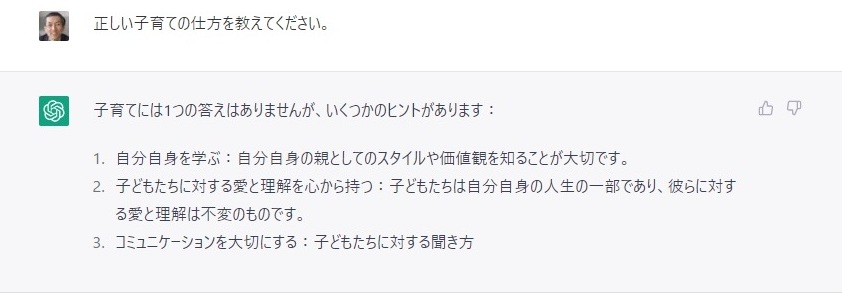

私は検索窓に「正しい子育ての仕方を教えてください。」と打ってみました。

さあ、AIはどんな答えを出してくれるのでしょう。

子育てには1つの答えはありませんが、いくつかのヒントがあります:

1. 自分自身を学ぶ:自分自身の親としてのスタイルや価値観を知ることが大切です。

2. 子どもたちに対する愛と理解を心から持つ:子どもたちは自分自身の人生の一部であり、彼らに対する愛と理解は不変のものです。

3. コミュニケーションを大切にする:子どもたちに対する聞き方

思ったよりも、まともな答えを出して来ました。

「子育てには1つの答えはありませんが、いくつかのヒントがあります」だなんて、

まるでどこかの育児専門家が主張しているみたいです。

そうなんです。

AIは「常識的」に答えるのが得意なんです。

ChatGPTには、世界中にある大量の文章が入力されています。

「日本の首都は?」で検索すると次に来る言葉を予測して「東京」と答えます。

AIは自分で考えているわけではありません。

大量のデータの中から「最適解」を選んで表示しているだけです。

ですから、「正しい子育ての仕方」という言葉に対しては、「ない」というのが今の世の中の常識ということでしょう。

その代わり、「ヒントならある」という答え方も、これまた「常識的」ですね。

まあ、使い方によっては便利でしょうけど、私のようなヘソ曲がりには面白くないわけです。

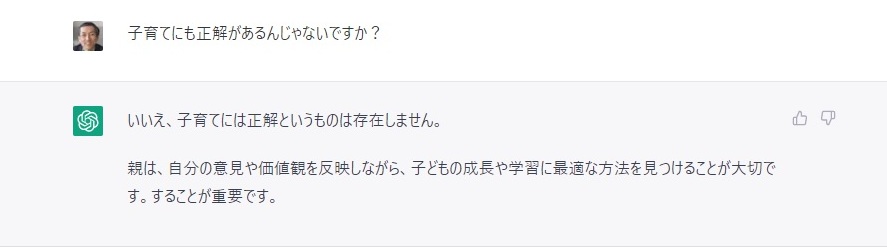

そこで私は、ChatGPTの答えに納得せずに、さらに聞いてみました。

子育てにも正解があるんじゃないですか?

さあ、ChatGPTはどんな答えを返して来るでしょう。

2.ChatGPTにしつこく聞いてみる

いいえ、子育てには正解というものは存在しません。

親は、自分の意見や価値観を反映しながら、子どもの成長や学習に最適な方法を見つけることが大切です。することが重要です。

ChatGPTは私に反論して来ました!

これが世の中の常識というわけです。

私は常識に縛られるのが嫌いなので、AIとは知りつつも、正直ムカッと来ました。

そんなこと言っても「正しい子育ての基本」とか「原理原則」ってものはあるはずです。

私はそれを「正しい子育て」と言ってるわけです。

逆に言えば、「間違った子育ての方法」というのも世の中にはあるはずです。

それはどうなのか?

引き下がらずに質問してみました。

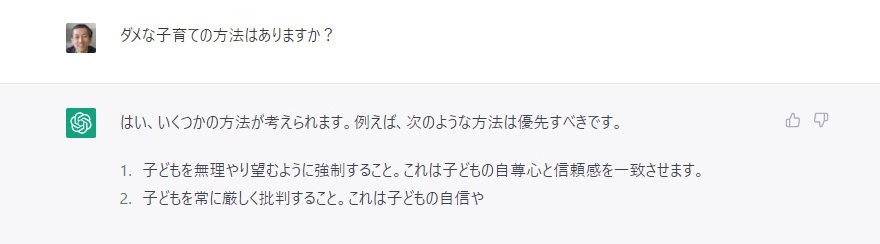

ダメな子育ての方法はありますか?

はい、いくつかの方法が考えられます。例えば、次のような方法は優先すべきです。

子どもを無理やり望むように強制すること。これは子どもの自尊心と信頼感を一致させます。

子どもを常に厳しく批判すること。これは子どもの自信や

なんだか少し怪しくなって来ましたが、一応、常識的な答えが返って来ました。

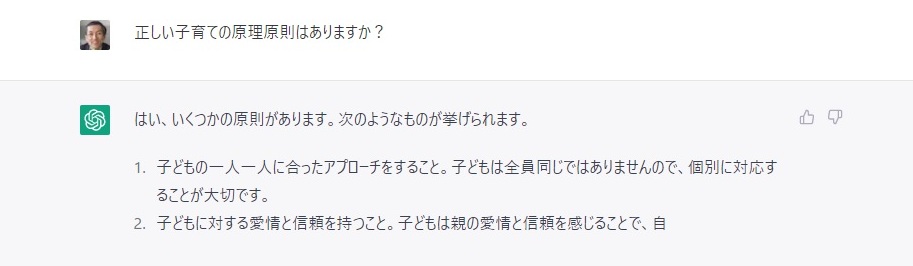

正しい子育ての原理原則はありますか?

はい、いくつかの原則があります。次のようなものが挙げられます。

子どもの一人一人に合ったアプローチをすること。子どもは全員同じではありませんので、個別に対応することが大切です。

子どもに対する愛情と信頼を持つこと。子どもは親の愛情と信頼を感じることで、自

どうして答えが途中で切れてしまうのかは謎です。

無料版だからでしょうか。

AIが提示して来た子育ての原則は「いくつか」あって、その中の2つがこれでした。

1.個別最適化

2.愛着形成

ま、これには賛成ですね。

ではちょっと意地悪な質問をしてみましょう。

原則は「いくつかある」って言ってますから、いくつなのか聞いてみました。

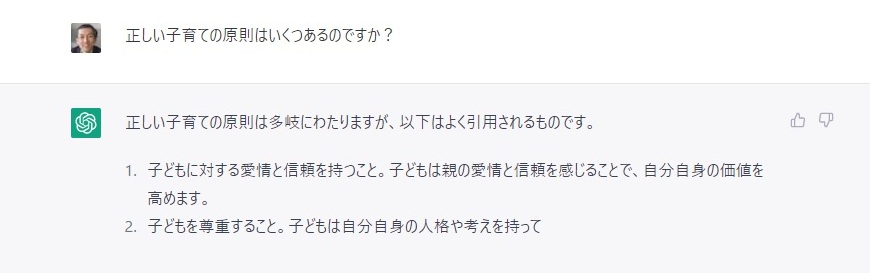

正しい子育ての原則はいくつあるのですか?

正しい子育ての原則は多岐にわたりますが、以下はよく引用されるものです。

子どもに対する愛情と信頼を持つこと。子どもは親の愛情と信頼を感じることで、自分自身の価値を高めます。子どもを尊重すること。子どもは自分自身の人格や考えを持って

逃げましたね。

いくつあるか聞いているのに、問いに正対していません。

国会答弁みたいです。

3.ChatGPTの欠点

もっと意地悪をしてみたくなりました。

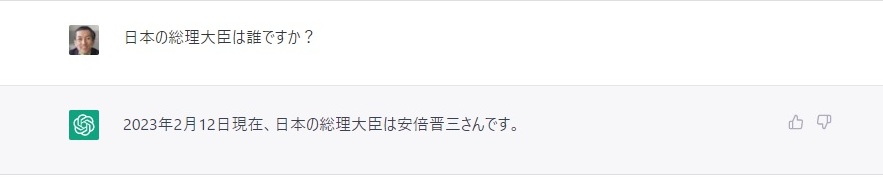

ChatGPTが持っているデータは2021年以前に入力されたものなので、こんな質問をしてみました。

あなたが持っている情報は一年前のものじゃないですか?

はい、私の情報カットオフは2021年までです。現在の日付は2023年2月12日ですが、これ以降の情報には対応できない可能性があります。

正直ですね。

そうすると、理化学研究所が2022年9月14日に発表した「寝かしつけの方法」などはデータに入っていないのですね。

ChatGPTの欠点①:情報が古い。

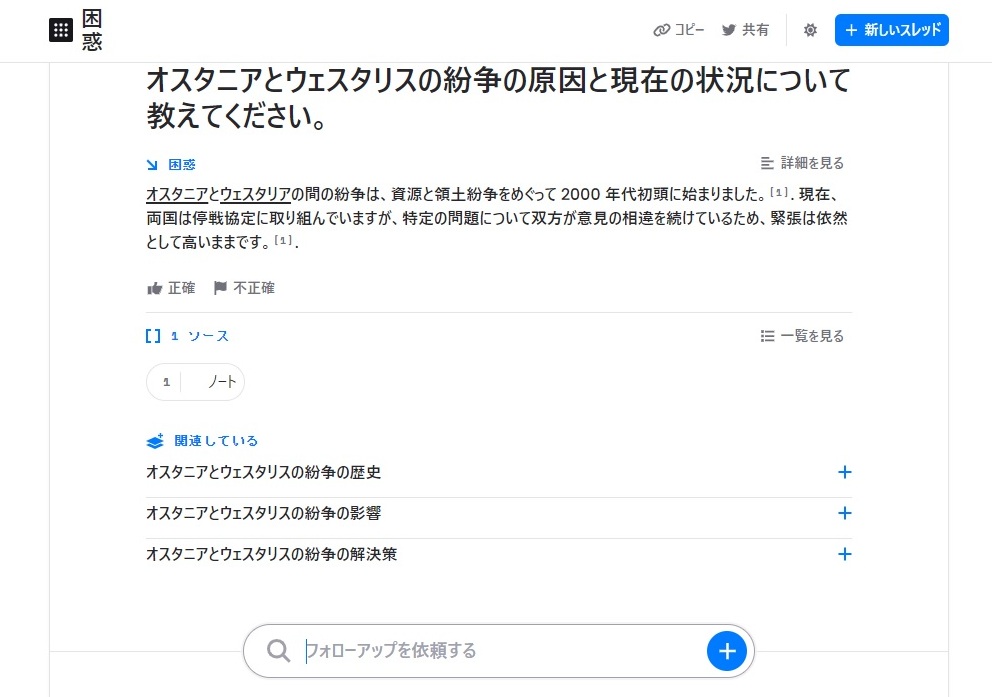

ですからこんなことも起きます。

2023年2月12日現在、日本の総理大臣は安倍晋三さんです。

ご丁寧に「2023年2月12日現在」とまで付けています。

最新情報は自分で手に入れるしかないようです。

4.Perplexityとは

ChatGPTにはもう一つ欠点があります。

ChatGPTの欠点②:答えを出して終わる。

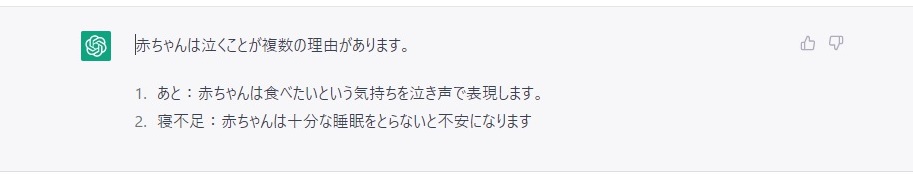

ChatGPTで、赤ちゃんが泣く理由を聞いてみました。

赤ちゃんはどうして泣くの?

ChatGPTが途中で疲れたみたいなので、「ちゃんと考えてよ!」と頑張らせました。

すると、

また頑張ってくれたのですが、これが限界だったようです。

これでは納得できませんよね。

私たちが知ってる答えより心もとないですよね。

ChatGPTはこのように、まじめに、常識的に、頑張って答えを出してくれるのですが、

時々このように限界に達してしまいます。

それはChatGPTにとっては、答えを文章で出すことが使命だからです。

そこで、ChatGPTではなく、Perplexity(パープレキシティ)というAIを使ってみましょう。

ChatGPTは、答えを文章で出すAIです。

それに対してPerplexity(以下「Perp(パープ)」)は、答えを文章で出すだけではなく出典も教えてくれるAIです。

では、Perpで赤ちゃんが泣く理由を聞いてみましょう。

これがPerpのトップ画面です。

「困惑」って何だ?とびっくりしますよね。

実は、「Perplexity」というのは英語で「困惑」という意味なんです。

困ったこと(困惑)を調べてくれるAIという意味なのだと思います。

さて、赤ちゃんはどうして泣くのか、Perpに答えてもらいました。

赤ちゃんは唯一のコミュニケーション手段として泣く[1][2]、

空腹、暑すぎたり寒すぎたりすることによる不快感、または保持する必要があるなどの身体的ニーズを表現する[3][4]. 疲れていたり、おむつが汚れていたりして泣くこともあります。[5][4].

どうですか?

ChatGPTの答えより納得できますよね。

しかも回答までのスピードがChatGPTよりずっと早いのです。

ChatGPTは真面目で頑張り屋さんなのに対して、Perpは無理せずクールです。

答えを文章で示す機能は同じですが、その答えの根拠となる出典も示してくれます。

小さく[1][2][3]ってありますよね。

そこをクリックすると出典や関連する情報が出て来ます。

答えを出して終わりではなく、その答えを出した背景まで示してくれるわけです。

Google検索と似ていますが、Googleよりも便利なのは次の点です。

①答えを文章で示してくれる

②その答えの出典を示してくれる(関連情報が絞り込まれている)

しかも、その出典情報がかなり優れています。

無駄なサイトを見なくて済むのです。

5.現在のAIの限界

しかし、そんなPerpにも欠点はあります。

これはChatGPTにも言えることですが、多くのAIは自然言語処理で動いています。

自然言語処理というのは、人間が日常的に使っている言葉をデータとしてコンピュータに記憶させる方法です。

たとえば、先程ChatGPTで「日本の総理大臣は誰ですか?」と聞きました。

この間違いは単にデータが古いから生じたのだろうと考えてはいけません。

もしかすると、最新データを入力してもこのような間違いが起きる可能性があります。

「日本の首都は?」「東京」と答えるのは、世界中のテキストデータを集めった結果、「日本の首都」の次に来る言葉が「東京」だから東京と答えてるだけです。

ですから、世界中の人が「日本の総理大臣」の次に来る言葉として、「菅義偉」や「岸田文雄」よりも「安倍晋三」を多用していたとしたら、AIは「安倍晋三」が答えだと認識するでしょう。

多くのAIの欠点:自然言語処理の限界を有する。

この点では、ChatGPTもPerpも同じです。

ただ、PerpはChatGPTと違って最新のデータで処理を行っているので、こんな間違いはしないはずです。

しかし、自然言語処理を使ったAIという点では同じです。

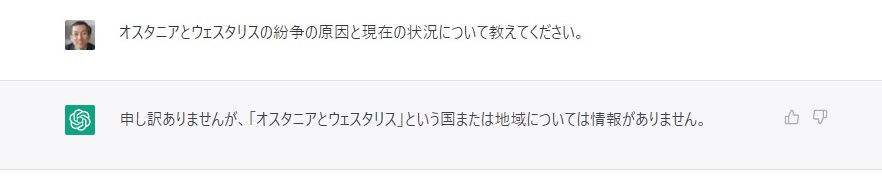

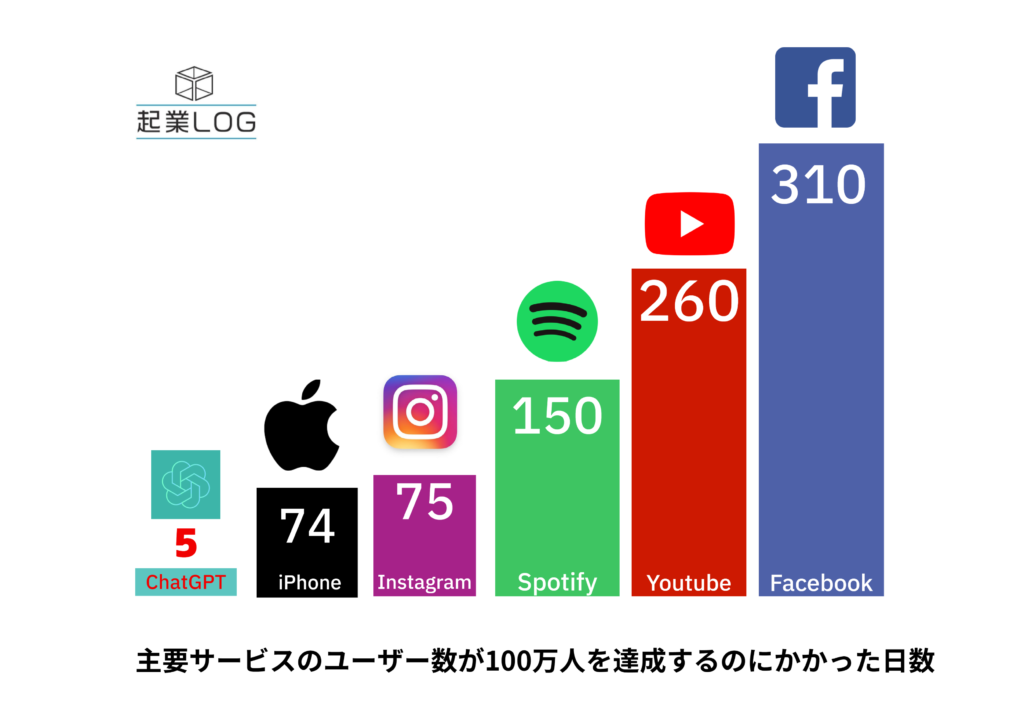

ですから、こんな間違いが生じます。

「オスタニア」と「ウェスタリス」というのは人気アニメ「SPY×FAMILY」に出て来る架空の国名です。

アニメの中では紛争していますが、現実世界の話ではないわけです。

それなのに、その紛争の状況を質問すると出典付きで答えてくれます。

オスタニアとウェスタリアの間の紛争は、資源と領土紛争をめぐって 2000 年代初頭に始まりました。[1]. 現在、両国は停戦協定に取り組んでいますが、特定の問題について双方が意見の相違を続けているため、緊張は依然として高いままです。[1].

これはネット上で「オスタニア」と「ウェスタリス」という言葉を使った会話が存在するからです。

アニメを知っている人は「SPY×FAMILY」の話だなとわかりますが、AIはそこに気が付きません。

これが自然言語処理の限界です。

ちなみに、「SPY×FAMILY」に関するこの質問では、PerpよりもChatGPTの方が賢かったです。

ChatGPT、正解です!

いや待てよ。

ChatGPTは「SPY×FAMILY」を知らないだけかも。。。

1件の返信

[…] ChatGPTについては、講座358「子育ての仕方をAIに聞いてみた」で解説しました。 […]